如何在嵌入式系统中运行 AI 推理服务

2025-03-15

在大语言模型和深度学习技术风靡全球的当下,AI 推理服务已成为工业、商业及消费领域的关键需求。然而,在智能工厂、农业监测、边缘网关等实际场景中,设备面临着硬件资源的严重限制。现场设备可能仅配备低端 CPU,内存仅有 KB 至 MB 级别,运行的是实时操作系统(RTOS)或精简版 Linux,甚至无法满足 Python 程序运行所需的依赖环境。

那么,如何在这种 “资源匮乏” 的环境中部署 AI 模型呢?本文将聚焦于轻量级框架 TensorFlow Lite,并结合景行人工智能平台的真实案例,详细解析从模型训练到嵌入式落地的完整流程。

一、嵌入式 AI 的 “生存法则”:轻量化与优化

传统的 AI 模型通常基于 TensorFlow 或 PyTorch 进行训练,训练过程依赖 GPU 服务器或高性能计算资源。但在嵌入式场景中,设备硬件条件往往不尽如人意:

- 算力不足:以 ARM Cortex-M 系列 CPU 为例,其主频仅为百兆赫兹,难以运行复杂模型。

- 内存限制:设备的 RAM 通常在 KB 至 MB 级别,无法加载标准的模型文件。

- 系统兼容性:RTOS 或微型 Linux 缺乏 Python 运行时环境。

二、TensorFlow Lite:嵌入式 AI 的 “瑞士军刀”

TensorFlow Lite 是 TensorFlow 的轻量化子集,专为移动端和嵌入式设备设计,具有以下核心优势:

- 1. 极致的轻量化

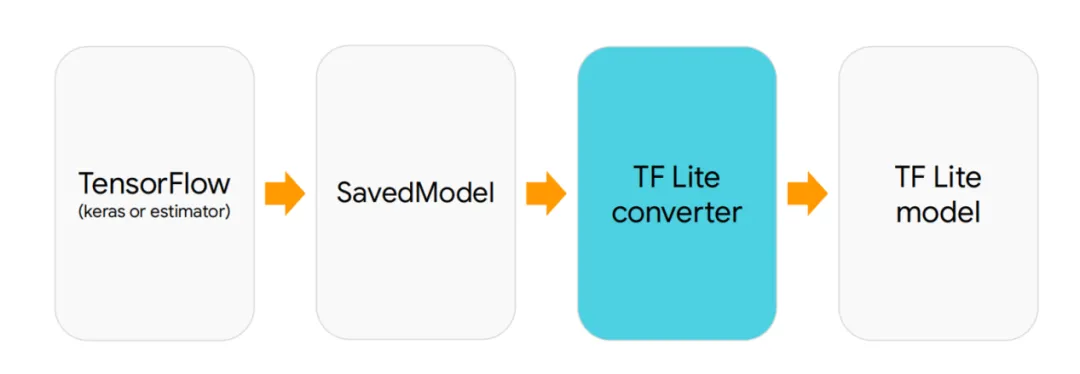

- a. 模型压缩:通过转换器(Converter)可将标准 TensorFlow 模型(.pb)转换为.tflite 格式。

- b. 量化支持:采用 8 位整数量化,能缩减模型体积 75%,同时推理速度可提升 2 - 3 倍,且精度损失在可控范围内。

- 2. 跨平台兼容性

- a. 支持多种平台:涵盖 Android、iOS、Raspberry Pi、RTOS(如 FreeRTOS)以及 MCU(如 Arduino)。

- b. 多语言接口:提供 C++/Java/Python 接口,适配不同的开发环境。

- 3. 硬件加速优化

- a. 集成加速模块:集成 GPU Delegate、Edge TPU Delegate 等硬件加速模块,有效提升推理效率。

- b. 支持动态调用:支持 NNAPI(Android 神经网络 API),可动态调用设备加速芯片。

- 4. 低内存消耗

- a. 低内存消耗:运行时内存占用仅为标准 TensorFlow 的 1/10,适合内存为 KB 级别的设备。

三、实战案例:手写识别模型部署到树莓派

在工业现场,常常需要部署手写文字识别服务。本案例以树莓派 5(1GB 内存,无 GPU)为设备进行部署。

模型转换流程

步骤 1:模型设计与训练

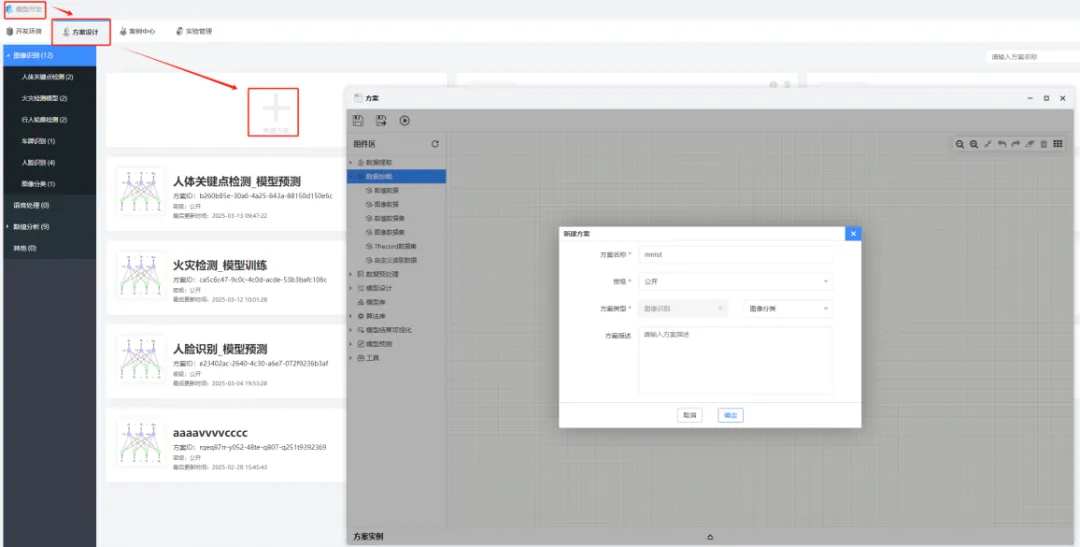

创建方案:在景行人工智能平台打开模型开发模块,选择 “方案设计”,点击 “新建方案”。输入方案名称,选择 “图像识别” 方案类型,创建模型训练方案。

新建方案

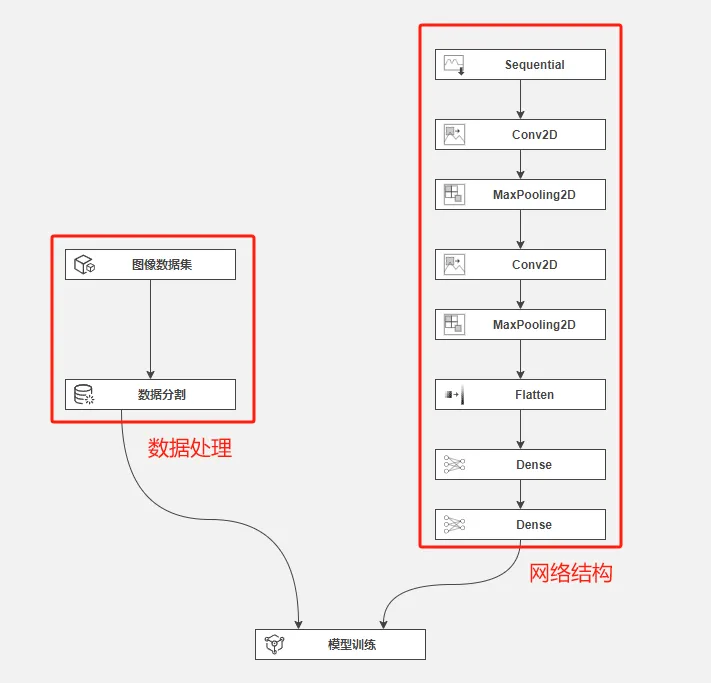

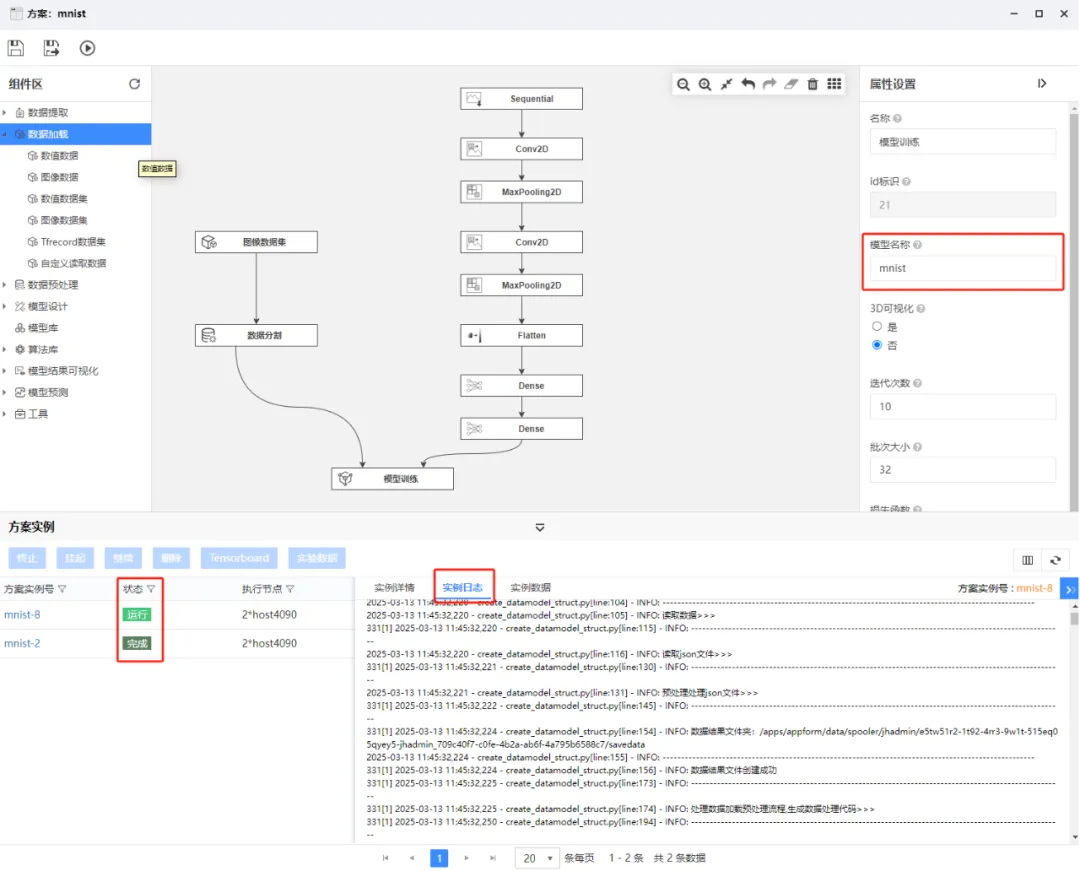

设计流程:在方案设计界面,通过拖拽组件并配置属性,构建由模型网络结构流程和数据处理流程组成的方案。

模型训练方案流程

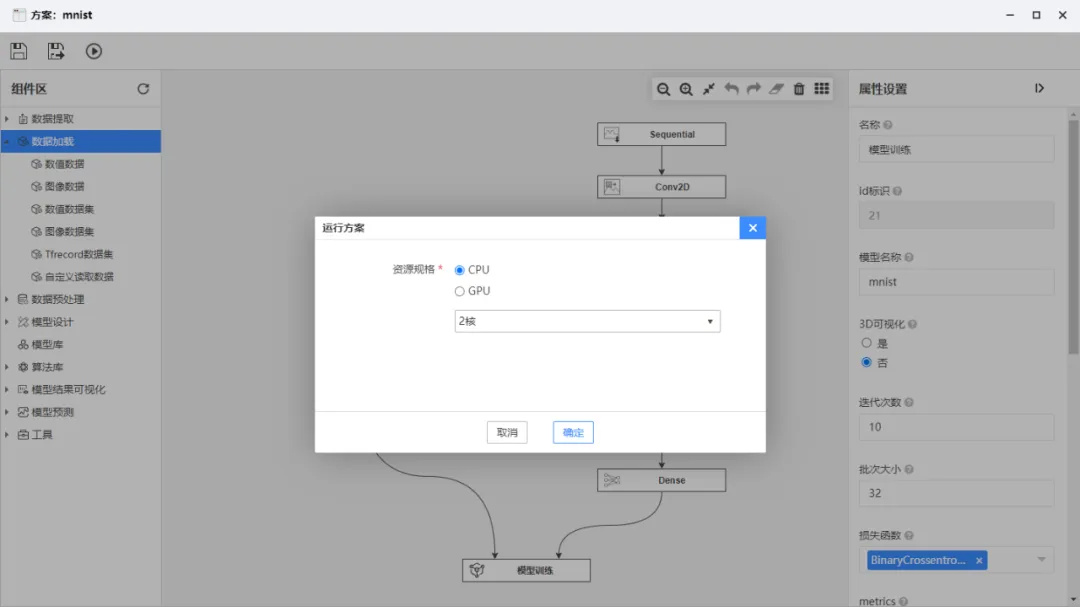

训练模型:方案设计完成后,选择运行资源,开始训练模型。训练过程中的日志会在方案实例的实例日志中动态输出,训练完成后模型会自动保存到模型库。由于模型参数等因素的调整,每次运行生成的模型会以不同版本保存。

选择训练资源

训练资源

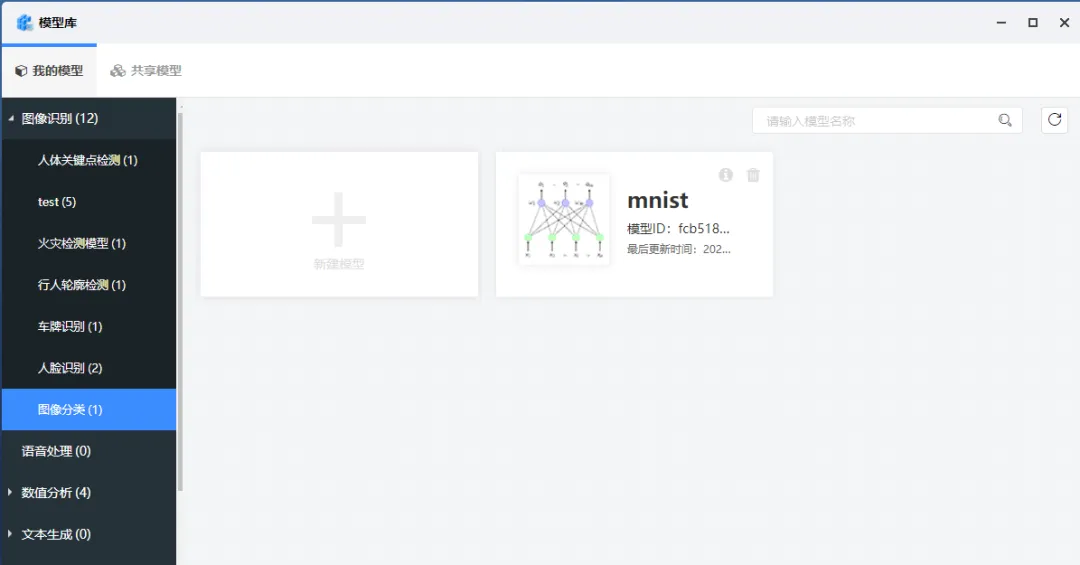

模型自动保存到模型库

模型列表

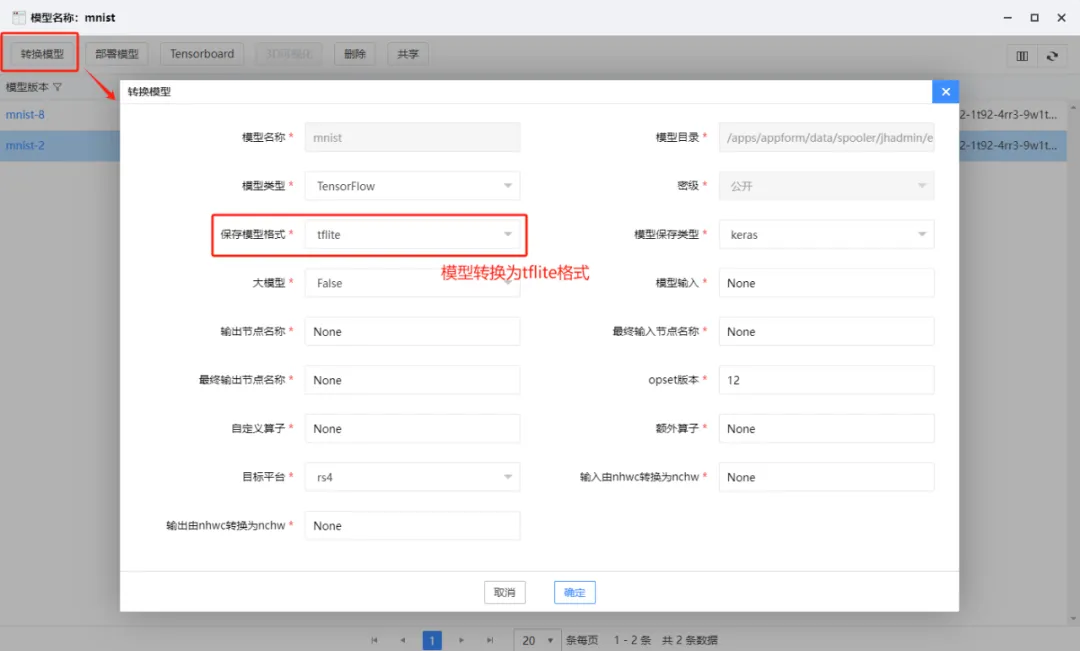

步骤 2:模型转换及推送

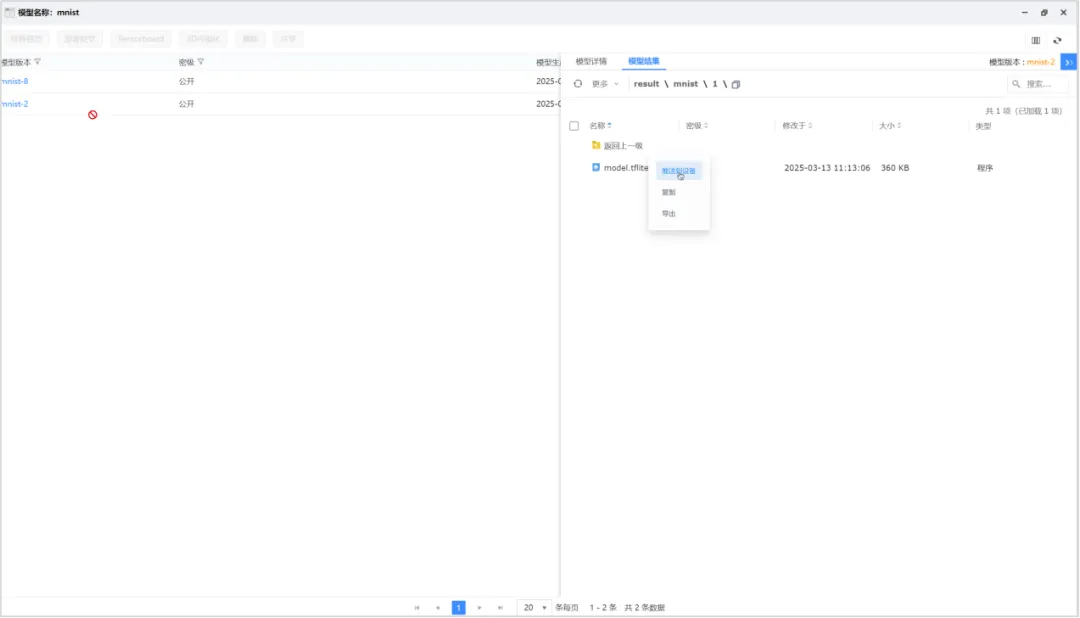

在景行人工智能平台的模型库中,选择具体的模型版本,点击 “转换模型”,设置相关参数,将模型转换并保存为.tflite 格式。模型转换会提交作业,完成后会在指定的模型目录下生成 tflite 文件,之后可一键推送到树莓派设备上。

模型转换

转换生成的tflite文件

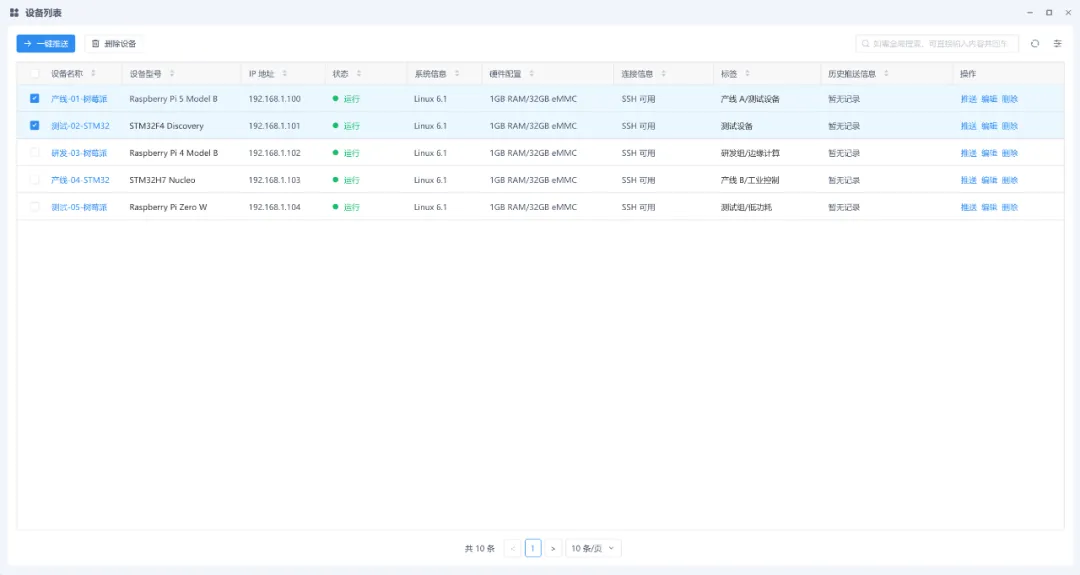

一键推送到设备

步骤 3:嵌入式运行环境部署

从景行人工智能平台导出适用于树莓派系统的 tensorflowlite,并推送到树莓派设备。同时,在平台的开发环境中编写 C++ 推理代码,代码主要包括加载模型、输入预处理、执行推理以及获取结果等步骤。

步骤 4:在嵌入式环境中运行模型

完成上述步骤后,即可在树莓派设备上运行手写识别模型,实现工业现场的手写文字识别服务。

四、景行人工智能平台:一站式嵌入式 AI 落地

通过上述实战案例可以看出,景行人工智能平台为用户实现嵌入式 AI 落地提供了便捷途径:

- 1. 模型设计:提供拖拽式模型设计工具,无需编程即可完成模型设计与修改。

- 2. 模型训练与微调:支持 TensorFlow/PyTorch 框架,并提供自动化超参优化。

- 3. 一键导出.tflite:平台内置模型压缩与量化工具,能适配嵌入式硬件。

- 4. 跨平台部署支持:可生成针对树莓派、STM32 等设备的定制化推理代码。

结语:嵌入式 AI 的广阔前景

从工业质检到智能家居,AI 推理服务正不断突破传统服务器机房的限制,向边缘设备延伸。借助 TensorFlow Lite 等轻量级工具,即使是资源有限的物联网设备,也能成为 AI 落地的重要节点。

立即行动:访问景行人工智能平台,开启您的嵌入式 AI 之旅!

联系我们

-

售前:sales@jhinno.com

售后:support@jhinno.com

-

010-84369601(北京)

029-89521139(西安)

4008875666分机:254401(传真)

-

销售热线:

13910720439(北京总部)

13519122505(西南区)

13438870307(西南区)

13991832535(西北区)

18653177303(华南区)

17665168855(华南区)

13260485348(华中区)

-

13324579433(技术支持热线)

-

微信公众号:JHinnovation